Erläuterung

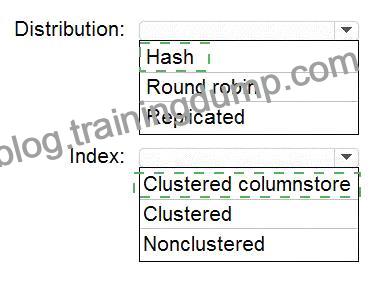

Kasten 1: Hash

Erwägen Sie die Verwendung einer Hash-verteilten Tabelle, wenn:

Die Tabellengröße auf der Festplatte beträgt mehr als 2 GB.

Die Tabelle hat häufige Einfüge-, Aktualisierungs- und Löschvorgänge.

Kasten 2: Geclusterter Spaltenspeicher

Geclusterte Columnstore-Tabellen bieten sowohl den höchsten Grad an Datenkompression als auch die beste Gesamtabfrageleistung.

Referenz:

https://docs.microsoft.com/en-us/azure/synapse-analytics/sql-data-warehouse/sql-data-warehouse-tables-distribu

https://docs.microsoft.com/en-us/azure/synapse-analytics/sql-data-warehouse/sql-data-warehouse-tables-index

Thema 1, Litware, Inc.

Fallstudie

Dies ist eine Fallstudie. Fallstudien werden nicht gesondert gewertet. Sie können so viel Zeit für die Prüfung aufwenden, wie Sie möchten, um jeden Fall zu bearbeiten. Es kann jedoch zusätzliche Fallstudien und Abschnitte in dieser Prüfung geben. Sie müssen Ihre Zeit so einteilen, dass Sie in der Lage sind, alle Fragen in der Prüfung in der vorgesehenen Zeit zu beantworten.

Um die Fragen in einer Fallstudie zu beantworten, müssen Sie sich auf Informationen beziehen, die in der Fallstudie enthalten sind. Fallstudien können Exponate und andere Ressourcen enthalten, die weitere Informationen über das in der Fallstudie beschriebene Szenario liefern. Jede Frage ist unabhängig von den anderen Fragen in dieser Fallstudie.

Am Ende dieser Fallstudie wird ein Überprüfungsbildschirm angezeigt. Hier können Sie Ihre Antworten überprüfen und Änderungen vornehmen, bevor Sie zum nächsten Abschnitt der Prüfung übergehen. Nachdem Sie einen neuen Abschnitt begonnen haben, können Sie nicht mehr zu diesem Abschnitt zurückkehren.

So beginnen Sie die Fallstudie

Um die erste Frage in dieser Fallstudie anzuzeigen, klicken Sie auf die Schaltfläche Weiter. Verwenden Sie die Schaltflächen im linken Fensterbereich, um den Inhalt der Fallstudie zu erkunden, bevor Sie die Fragen beantworten. Wenn Sie auf diese Schaltflächen klicken, werden Informationen wie z. B. die Geschäftsanforderungen, die vorhandene Umgebung und die Problemstellung angezeigt. Wenn die Fallstudie über eine Registerkarte Alle Informationen verfügt, beachten Sie, dass die angezeigten Informationen identisch mit den Informationen sind, die auf den nachfolgenden Registerkarten angezeigt werden. Wenn Sie bereit sind, eine Frage zu beantworten, klicken Sie auf die Schaltfläche Frage, um zu der Frage zurückzukehren.

Übersicht

Litware, Inc. besitzt und betreibt 300 Convenience Stores in den USA. Das Unternehmen verkauft eine Vielzahl von verpackten Lebensmitteln und Getränken sowie eine Reihe von Fertiggerichten wie Sandwiches und Pizzen.

Litware hat einen Treueclub, in dem Mitglieder täglich Rabatte auf bestimmte Artikel erhalten können, wenn sie an der Kasse ihre Mitgliedsnummer angeben.

Litware beschäftigt Business-Analysten, die es vorziehen, Daten mit Microsoft Power BI zu analysieren, und Datenwissenschaftler, die es vorziehen, Daten in Azure Databricks Notebooks zu analysieren.

Anforderungen

Geschäftliche Ziele

Litware möchte eine neue Analyseumgebung in Azure erstellen, um die folgenden Anforderungen zu erfüllen:

Übersicht über die Lagerbestände in allen Filialen. Die Daten müssen so weit wie möglich in Echtzeit aktualisiert werden.

Führen Sie analytische Ad-hoc-Abfragen zu historischen Daten durch, um festzustellen, ob die Treueclub-Rabatte den Absatz der rabattierten Produkte steigern.

Informieren Sie die Filialmitarbeiter alle vier Stunden darüber, wie viele zubereitete Lebensmittel auf der Grundlage der historischen Nachfrage aus den Verkaufsdaten zu produzieren sind.

Technische Anforderungen

Litware stellt die folgenden technischen Anforderungen fest:

Minimieren Sie die Anzahl der verschiedenen Azure-Dienste, die zum Erreichen der Geschäftsziele erforderlich sind.

Nutzen Sie wann immer möglich PaaS-Angebote (Platform as a Service) und vermeiden Sie die Bereitstellung virtueller Maschinen, die von Litware verwaltet werden müssen.

Stellen Sie sicher, dass der analytische Datenspeicher nur für das lokale Netzwerk des Unternehmens und die Azure-Dienste zugänglich ist.

Verwenden Sie wann immer möglich die Azure Active Directory (Azure AD)-Authentifizierung.

Anwendung des Prinzips der geringsten Privilegien bei der Gestaltung der Sicherheit.

Inventarisierungsdaten in Azure Data Lake Storage Gen2 vor dem Laden der Daten in den analytischen Datenspeicher. Litware möchte transiente Daten aus Data Lake Storage entfernen, sobald sie nicht mehr verwendet werden.

Dateien mit einem Änderungsdatum, das älter als 14 Tage ist, müssen entfernt werden.

Beschränken Sie den Zugriff der Unternehmensanalysten auf Kundenkontaktinformationen wie Telefonnummern, da diese Art von Daten für die Analyse nicht relevant ist.

Stellen Sie sicher, dass Sie im Falle einer Beschädigung oder versehentlichen Löschung innerhalb einer Stunde eine Kopie des analytischen Datenspeichers wiederherstellen können.

Geplante Umwelt

Litware plant, die folgende Umgebung zu implementieren:

Das Anwendungsentwicklungsteam wird einen Azure-Event-Hub erstellen, um Echtzeit-Verkaufsdaten, einschließlich Filialnummer, Datum, Uhrzeit, Produkt-ID, Kundenbindungsnummer, Preis und Rabattbetrag, vom Kassensystem zu empfangen und die Daten an den Datenspeicher in Azure auszugeben.

Kundendaten, einschließlich Name, Kontaktinformationen und Kundennummer, stammen aus Salesforce, einer SaaS-Anwendung, und können einmal alle acht Stunden in Azure importiert werden. Das Datum der Zeilenänderung ist in der Quelltabelle nicht vertrauenswürdig.

Produktdaten, einschließlich Produkt-ID, Name und Kategorie, stammen aus Salesforce und können einmal alle acht Stunden in Azure importiert werden. Zeilenänderungsdaten sind in der Quelltabelle nicht vertrauenswürdig.

Die täglichen Bestandsdaten stammen von einem Microsoft SQL-Server, der sich in einem privaten Netzwerk befindet.

Litware verfügt derzeit über 5 TB an historischen Verkaufsdaten und 100 GB an Kundendaten. Das Unternehmen erwartet für das nächste Jahr etwa 100 GB an neuen Daten pro Monat.

Litware wird eine benutzerdefinierte Anwendung namens FoodPrep entwickeln, die den Mitarbeitern in den Geschäften die Berechnungsergebnisse darüber liefert, wie viele zubereitete Lebensmittel sie alle vier Stunden produzieren müssen.

Litware plant nicht, Azure ExpressRoute oder ein VPN zwischen dem lokalen Netzwerk und Azure zu implementieren.